Cos’è l’IA costituzionale?

Quando i membri uscenti di OpenAI lanciarono una startup incentrata sull’intelligenza artificiale, ciò provocò onde d’urto in tutta la Silicon Valley. Quando l’azienda Anthropic ha rivelato il suo potente chatbot, Claude, le ondate sono aumentate. La società ha attirato una straordinaria quantità di capitali di investimento, raggiungendo i miliardi durante i suoi primi due anni. Claude potrebbe non rappresentare il contributo più significativo di Anthropic in questo campo. La società è anche responsabile di un’iniziativa meno appariscente ma più sostanziale chiamata Constitutional AI. Alcuni sperano che questa iniziativa possa dare forma al futuro della sicurezza dell’intelligenza artificiale.

L’intelligenza artificiale ha faticato a trovare un punto d’appoggio rilevante sui dispositivi mobili , ma continua a entrare nelle nostre vite, dai compiti a casa e dalla ricerca legale alla guida dei migliori altoparlanti intelligenti . I vincoli di sicurezza rappresentano una preoccupazione crescente per sviluppatori e consumatori. Cos’è l’intelligenza artificiale costituzionale e perché è importante per il futuro della sicurezza dell’intelligenza artificiale?

L’intelligenza artificiale costituzionale aderisce ai valori umani

L’intelligenza artificiale costituzionale è un insieme di strumenti e tecniche che garantiscono che l’intelligenza artificiale sia strettamente allineata ai valori umani, assicurandosi che sia utile, innocua ed eviti pratiche ingannevoli. Anthropic ha sviluppato e registrato il concetto di intelligenza artificiale costituzionale e la società ha creato una Costituzione per modelli linguistici di grandi dimensioni. Questa Costituzione garantisce che le IA come Claude di Anthropic aderiscano ai valori umani chiaramente definiti dagli autori della Costituzione, piuttosto che apprendere o ereditare valori durante la sua formazione ed evoluzione a causa dell’elaborazione di enormi quantità di dati.

Come funziona l’intelligenza artificiale costituzionale?

In un documento pubblicato sul sito web dell’azienda chiamato Claude’s Constitution, Anthropic ha descritto come definisce i valori dell’intelligenza artificiale facendo sì che gli esseri umani selezionino il meglio dei molteplici risultati dell’intelligenza artificiale. Ciò ha generato preferenze che l’intelligenza artificiale ha utilizzato per influenzare i risultati futuri, rendendo idealmente il sistema più accurato e utile.

Questo approccio presentava diversi limiti e sarebbe stato difficile da scalare man mano che l’intelligenza artificiale diventava più complessa, veloce e sofisticata. Significava anche che gli operatori umani avrebbero spesso avuto a che fare con risultati inquietanti dell’IA.

Per migliorare questo processo, Anthropic ha spostato il monitoraggio e la regolamentazione del comportamento sull’intelligenza artificiale. L’intelligenza artificiale costituzionale addestra un’intelligenza artificiale su diversi principi fondamentali volti a evitare risultati tossici, dannosi o discriminatori, evitare di aiutare le persone a impegnarsi in attività illegali e concentrarsi sullo sviluppo di sistemi di intelligenza artificiale che siano etici e utili.

Il modello viene introdotto a questi principi guida e poi alimentato con esempi. L’AI ha il compito di analizzare e affinare le sue risposte per allinearle ai principi costituzionali. Attraverso l’apprendimento per rinforzo, in cui l’IA viene premiata per risultati appropriati e penalizzata per risultati che violano tali principi, l’IA sviluppa una politica che modella comportamenti e risposte futuri.

Il futuro dell’intelligenza artificiale costituzionale

Anthropic ha affermato che uno dei motivi principali per cui è stata fondata l’azienda è stato quello di perseguire la ricerca sulla sicurezza dell’intelligenza artificiale. A giudicare dalla litania di rapporti che l’azienda pubblica continuamente sul suo sito, questa filosofia sembra essere valida. Alcune delle ricerche che stanno conducendo sono estremamente interessanti e preziose dal punto di vista pratico.

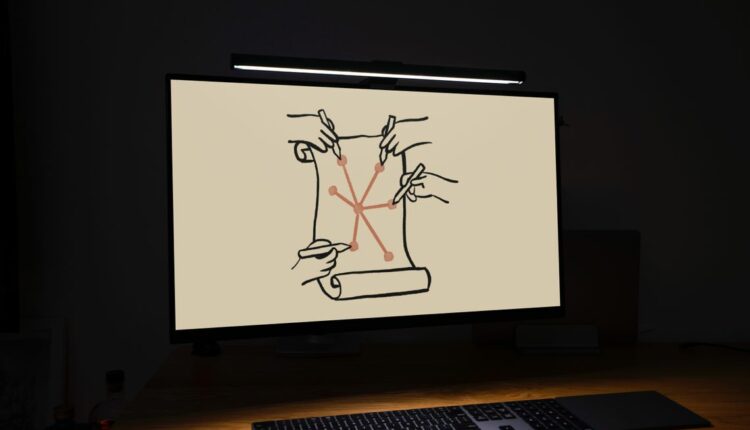

n ottimo esempio è un articolo Anthropic pubblicato nell’ottobre 2023 che descrive in dettaglio i risultati di un esperimento con l’IA costituzionale collettiva. Anthropic ha invitato circa 1.000 partecipanti a presentare idee su cosa dovrebbe essere incluso in una costituzione sull’intelligenza artificiale. Ha confrontato i risultati del sondaggio con la costituzione interna dell’azienda. I ricercatori hanno poi addestrato un’intelligenza artificiale sulla Costituzione collettiva e l’hanno confrontata con i risultati della formazione sulla costituzione interna.

La costituzione pubblica includeva alcune differenze notevoli rispetto alla costituzione interna di Anthropic, come l’enfasi nel fornire risposte che bilanciassero tutti gli aspetti di una questione o dibattito o risposte che fossero più accessibili alle persone con disabilità.

Anthropic ha addestrato due dei suoi modelli più piccoli di Claude Instant AI. Uno sulla Costituzione Collettiva e uno sulla sua costituzione interna. Si è scoperto che i modelli si comportavano in modo simile nei compiti di matematica e di comprensione del linguaggio, condividevano ideologie politiche simili ed erano utili e innocui l’uno rispetto all’altro. Tuttavia, il modello addestrato dal pubblico ha mostrato meno pregiudizi in nove dimensioni sociali in un benchmark di pregiudizio , come illustrato di seguito.